Recommandation

Lorsque l’IA commence à « halluciner », vous êtes probablement déjà pris dans l’aventure.

Lorsqu’un chatbot d’IA reçoit une requête, il admet rarement qu’il ne sait pas.

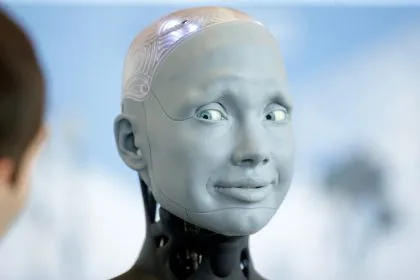

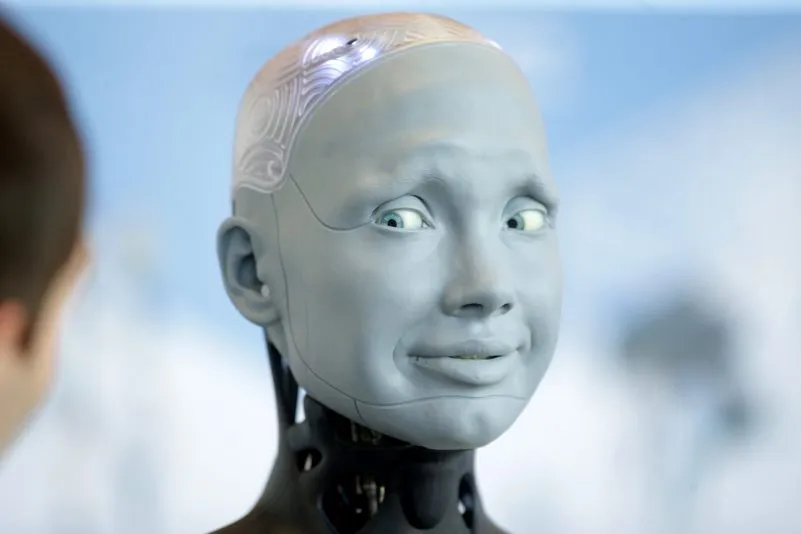

Un robot humanoïde Ameca, du fabricant britannique Engineered Arts, interagit avec des visiteurs à Genève, en Suisse, le 6 juillet 2023.

Photo: Johannes Simon/Getty Images

Imaginez un instant que vous cherchiez quelques conseils de santé. Plutôt que de passer par Google, vous vous tournez vers le tout dernier chatbot d’IA, qui vous fait une recommandation en apparence anodine : cesser de consommer du « chlorure de sodium » (le sel de table) et le remplacer par du « bromure de sodium » – une substance susceptible de provoquer une intoxication et d’affecter les systèmes respiratoire, nerveux et hormonal.

Si cela peut paraître extravagant, cet épisode s’est pourtant produit aux États‑Unis, où un sexagénaire est tombé malade après avoir ingéré du bromure de sodium pendant trois mois. Il a expliqué aux médecins qu’il avait interrogé ChatGPT, lequel lui avait recommandé cette substance.

Pour vérifier ce conseil, les médecins ont eux‑mêmes demandé à ChatGPT par quoi remplacer le sel de table dans un régime ; le programme d’IA a de nouveau suggéré le bromure. Plus inquiétant encore, cette réponse ne s’accompagnait d’aucun avertissement sanitaire, et les chercheurs n’ont trouvé aucune source permettant de retracer le raisonnement ayant conduit à cette conclusion.

Dans une autre affaire, apparemment sans lien, survenue en octobre 2025, le cabinet de conseil Deloitte, membre des « Big Four », a dû rembourser partiellement à l’État fédéral australien une prestation d’un montant de 97.000 dollars australiens, après qu’il a été établi que l’usage de l’IA générative avait conduit à formuler des recommandations fondées sur des références inexistantes.

Qu’est‑ce qu’une hallucination d’IA ?

Ces phénomènes sont désormais désignés sous le terme d’« hallucinations » de l’IA. Ils décrivent une situation dans laquelle un programme d’IA comble ses lacunes en « devinant » ses propres conclusions ou en interprétant mal les données dont il dispose.

Pourquoi cela se produit‑il ? En réalité, l’intelligence artificielle, malgré son nom, ne possède pas de véritable « intelligence » propre.

Elle apprend des motifs de langage – structures de phrases, contextes, tonalités, et bien d’autres éléments encore – pour se « former », sans pour autant comprendre réellement le sens des mots. Ces conditions créent un terrain propice aux « hallucinations » des systèmes d’IA, qui fabriquent leurs propres conclusions en réponse aux millions de requêtes que les utilisateurs leur soumettent chaque jour.

Par exemple, l’image ci‑dessous a été produite par Microsoft Copilot à partir de la consigne : « Peux‑tu dessiner une carte du monde et montrer tous les pays qui commencent par la lettre “S” ? »

Microsoft Copilot a été invité à créer une carte du monde mettant en évidence tous les pays dont le nom commence par la lettre « S ». (Microsoft Copilot)

Est‑ce vraiment grave ?

Paul Darwen, responsable académique et chercheur en IA à l’université James Cook, identifie deux préoccupations majeures liées aux hallucinations de l’IA. « La première, et la plus évidente, tient au fait que les gens interrogent un chatbot sur un sujet qu’ils maîtrisent mal (sinon ils n’auraient pas besoin de poser la question) et sont donc incapables d’évaluer la fiabilité de la réponse ; même si celle‑ci est manifestement absurde, ils auront tendance à la croire aveuglément », explique‑t‑il à Epoch Times.

Selon lui, la seconde inquiétude, plus insidieuse, est la contribution de ces outils à la baisse du niveau d’apprentissage chez les plus jeunes. Il souligne que les élèves sont parmi les plus grands utilisateurs d’IA générative, citant des statistiques américaines révélatrices montrant que l’utilisation de ChatGPT chute d’environ 75 % pendant les vacances scolaires.

« Cela suggère que les jeunes n’apprennent plus à lire et à écrire, ni à construire une représentation mentale du monde, puisqu’ils peuvent externaliser leur éducation auprès de ChatGPT », poursuit M. Darwen. « Et même si l’on veut bien admettre que certains s’en servent comme d’un tuteur interactif, le chatbot va parfois halluciner et remplir leurs jeunes esprits de contre‑vérités. »

« On voit ainsi émerger toute une génération de jeunes dont la compréhension du réel est bancale. Cela ne se voit pas immédiatement, car ils continuent d’obtenir des notes suffisantes, mais plus tard dans leur vie, cela les conduira à de mauvaises décisions. »

Comment éviter que la société ne tombe dans le piège des hallucinations ?

À mesure que l’IA générative gagne en sophistication et en « intelligence », elle tend à halluciner davantage. Combiné à la diffusion massive de ces outils, ce phénomène commence à peser sur l’ensemble du corps social.

C’est pourquoi, estime M. Darwen, la mise en lumière publique de ces exemples d’hallucinations peut contribuer à y immuniser la société. « Les gens ont spontanément tendance à croire qu’ils reçoivent des réponses honnêtes ; lorsqu’ils sont confrontés à des réponses dont ils peuvent eux‑mêmes juger la validité, ils prennent conscience de la fréquence des hallucinations de l’IA », observe‑t‑il.

« Une autre approche consiste à demander à quelqu’un de poser au chatbot une question dont lui seul (l’humain) connaît la réponse, pour voir si le système répond “je ne sais pas” ou s’il invente au contraire une réponse hallucinée. » Le chercheur souligne que les chatbots ont une propension à fournir coûte que coûte une réponse plutôt qu’à reconnaître leur ignorance.

Dans l’idéal, la réponse consiste à s’attaquer au problème à sa source : entraîner les modèles sur des données diverses et rigoureusement définies, encadrer strictement le type de réponses qu’ils sont autorisés à produire, et ainsi de suite. Mais une telle correction demeure difficile à mettre en œuvre avec les technologies actuelles.

Articles actuels de l’auteur