ChatGPT a rejeté plus de 250.000 demandes de création d’images de candidats à la présidence avant les élections

Le logo de l'application ChatGPT sur l'écran d'un smartphone (à g.) et les lettres AI sur l'écran d'un ordinateur portable à Francfort-sur-le-Main, en Allemagne, le 23 novembre 2023.

Photo: Kirill Kudryavtsev/AFP via Getty Images

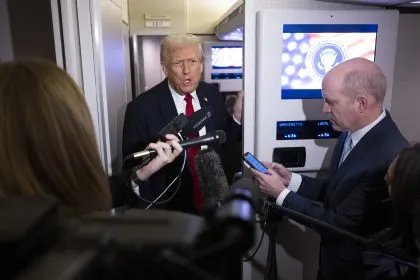

OpenAI a déclaré vendredi que ChatGPT avait refusé plus de 250.000 demandes de génération d’images de candidats à la présidence des États-Unis avant les élections générales du 5 novembre.

Le chatbot d’intelligence artificielle (IA) a bloqué les demandes de génération d’images de l’ancien président Donald Trump, de la vice-présidente Kamala Harris, du président Joe Biden, du gouverneur du Minnesota Tim Walz et du sénateur JD Vance (Parti républicain de l’Ohio) au cours du mois qui a précédé le jour de l’élection, a déclaré OpenAI.

« Nous avons appliqué des mesures de sécurité à ChatGPT pour refuser les demandes de génération d’images de personnes réelles, notamment de politiciens », a déclaré la société dans un article de blog le 8 novembre.

« Ces garde-fous sont particulièrement importants dans un contexte électoral et constituent un élément clé de nos efforts accrus pour empêcher que nos outils soient utilisés à des fins trompeuses ou préjudiciables », a ajouté la société.

ChatGPT a également dirigé les questions sur le vote aux États-Unis vers CanIVote.org conformément aux mesures de sécurité adoptées en cette période électorale, selon l’article de blog.

OpenAI a déclaré qu’elle s’était concentrée sur l’identification et l’interruption de tentatives d’utilisation de ses modèles pour générer du contenu destiné à des opérations d’influence secrètes ciblant les élections mondiales de cette année.

L’entreprise a déclaré qu’il n’y avait aucune preuve d’opérations secrètes visant à influencer l’élection américaine en bénéficiant d’un engagement viral ou en construisant des audiences durables grâce à l’utilisation de ses modèles.

Dans son rapport d’octobre, OpenAI indique avoir interrompu plus de 20 opérations et réseaux trompeurs dans le monde entier qui tentaient d’utiliser ses modèles pour des activités telles que le débogage de logiciels malveillants, la rédaction d’articles pour des sites web et la génération de contenu publié par de fausses personnalités sur des comptes de médias sociaux.

Le rapport indique qu’OpenAI a interrompu des efforts de création de contenu de médias sociaux sur les élections aux États-Unis, au Rwanda, en Inde et dans l’Union européenne, mais que rien ne permet d’affirmer que ces réseaux ont été en mesure de susciter un engagement viral ou de construire une audience durable à l’aide de ses outils.

« Les auteurs de menaces continuent d’évoluer et d’expérimenter nos modèles, mais nous n’avons pas vu de preuves démontrant que de telles initiatives ont conduit à des percées significatives dans leur capacité à créer des logiciels malveillants inédits ou à établir des audiences virales », peut-on lire dans le rapport.

Au début de l’année, un groupe de 20 grandes entreprises technologiques, dont OpenAI, Google et Meta, ont signé un pacte affirmant leur engagement à lutter contre l’utilisation trompeuse de l’IA pour les élections de cette année dans le monde entier.

L’accord porte plus particulièrement sur les sons, les vidéos et les images générés par l’IA et destinés à tromper les électeurs et à manipuler les processus électoraux. Les entreprises se sont engagées à « travailler en collaboration » pour renforcer leurs efforts dans ce domaine, selon un communiqué de presse.

Les entreprises signataires ont convenu de huit actions, notamment développer une technologie permettant de détecter et de traiter les « deepfakes », atténuer les risques, favoriser la résilience interindustrielle et assurer la transparence de leurs efforts auprès du public.

Caden Pearson a participé à la rédaction de cet article.

Aldgra Fredly est une rédactrice indépendante qui couvre l'actualité des États-Unis et de la région Asie-Pacifique pour le journal Epoch Times.

Articles actuels de l’auteur